Disse teknologier kan forebygge deepfakes

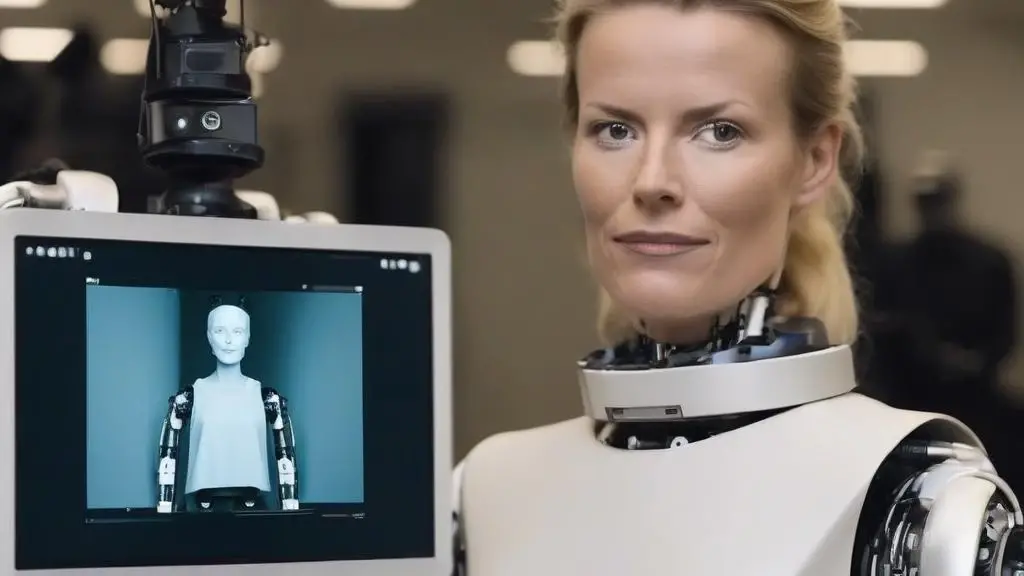

"Deepfakes breder sig som ringe i vandet og ofrene er alt fra unge piger, der får deres ansigter misbrugt i pornofilm til den amerikanske præsident som rapper og senest Mette Frederiksen i en kampagnevideo for DF. Som forbruger kan det være vanskeligt at skelne ægte indhold fra falskt” Men der er løsninger på dele af problemerne”, siger IT-politisk rådgiver hos PROSA, Ole Tange.

> Læs også: Hvorfor skal borgerne selv lægge arm med kriminelle og med Meta?

Kan vi skelne mellem ægte og AI-genereret indhold?

”En af de teknologier som kan forebygge deepfakes er Content Credentials eller Content Authenticity. Det er en teknologi som gør, at man kan placere metadata på billeder så man kan se, hvor billedet kommer fra. Det er lidt ligesom at bruge Git eller Blockchain-teknologi, hvor man skaber et digitalt fingeraftryk. Det gør det ikke umuligt at skabe deepfakes, men det giver de ærlige mulighed for at tilføje metadata og sige, 'Her er kilden til det, vi har lavet.”

Hvornår kan det implementeres?

”Content Credentials er stadig i sin spæde start, men vi forventer, at det bliver en åben standard. Kildekoden er allerede tilgængelig, så alle kan benytte sig af det. Kameraproducenter som Leica har indbygget det i deres kameraer, så billederne kan signeres digitalt. På sigt må man forvente, at det også implementeres i almindelige kameraer og mobiltelefoner, så alle kan bruge det. Det skal være nemt at verificere ægtheden af et billede.”

Hvordan kan vi kontrollere brugen af deepfake-teknologi?

”Jeg tror, at vi vil se en fortsat udvikling af deepfake-teknologi, både i form af mere avancerede manipulationsteknikker. Derfor er det en kompleks udfordring, der kræver et samarbejde mellem lovgivere, teknologibranchen og samfundet. Lovgivning kan være en del af løsningen, men det er også vigtigt at de sociale medier kommer med på vognen. F.eks. kan man forestille sig, at sociale mediers algoritmer kan belønne billeder og videoer, der bruger Content Credentials. Hvis det er for besværligt for folk at kontrollere, om et billede er manipuleret, vil de ikke gøre det.”

Kan man ikke bare bygge en robot?

”Et af de spørgsmål, som jeg oftest bliver stillet er, om man ikke bare kan bygge en robot, der kan adskille ægte fra genererede medier. Det kan man ikke. Hvis man lavede en sådan robot, kunne den også bruges til at træne en AI til at generere billeder, som robotten ikke ville kunne opdage, og derfor vil AI på sigt vinde dette våbenkapløb. Derfor ser jeg teknologier, der verificerer og deklarerer indholdet, som en mere langsigtet løsning mod deepfakes.”